개요

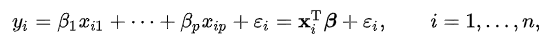

회귀모델에서 설명변수가 많을 경우에는 설명변수를 줄일 필요가 있습니다. 설명변수가 많으면 예측 성능이 좋지 않기 때문이죠. 많은 설명변수를 가지는 회귀분석의 경우 설명변수들사이의 독립성 등의 가정을 만족시키기 어렵습니다. 또한 설명변수의 증가는 모형의 결정계수 등을 증가시키기는 하지만 다중 공선성 문제 등을 일으키므로 결과적으로 추정의 신뢰성을 저하시킵니다.

그렇다면 설명변수를 줄여주는 방법은 무엇이 있을까요 ?

변수 선택 방법(variable selection)

위에서 말한 설명변수를 줄여주는 것은 다시 말해 유의미한 설명변수를 선택하는 방법이겠죠 ?

변수를 선택하는 방법에는 다음과 같은 세가지 방법이 있습니다.

1. Subset Selection

- 1부터 p까지 k개에 대해 모델을 쭈욱 구하고 RSS(잔차제곱합), 결정계수 등을 보고 결정합니다.

- 하지만 p가 크면 계산하기 거의 불가능에 가까운 숫자기 때문에 stepwise 방법을 씁니다.

- stepwise 방법

1)전진 선택법 (forward selection): 절편만 있는 모델에서 기준 통계치를 가장 많이 개선시키는 변수를 차례로 추가하는 방법

2)후진 소거법(backward elimination): 모든 변수가 포함된 모델에서 가장 도움이 되지 않는 변수(p값)를 하나씩 제거하는 방법

3)단계 선택법(stepwise selection): 모든 변수가 포함된 모델에서 출발하고 기준통계치에 가장 도움이 되지 않는 변수를 삭제하거나 모델에서 빠져있는 변수 중에서 기준 통계치를 가장 개선시키는 변수를 추가함. 이러한 변수의 추가 또는 제거를 반복함.

2. Shrinkage

- OLS 말고 다른 방법으로 fitting을 해서 test error가 줄어들게 만드는 것 입니다.

- Shrinkage 방법은 아래의 글을 확인하면 됩니다.

Ridge regression(릿지 회귀)와 Lasso regression(라쏘 회귀) 쉽게 이해하기

Ridge regression와 Lasso regression를 이해하려면 일단 정규화(regularization)를 알아야합니다. 첫번째 그림을 보면 직선 방정식을 이용하여 선을 그었습니다. 데이터와 직선의 차이가 꽤 나네요. 정확한 ��

rk1993.tistory.com

3. Dimension Reduction

- p개의 predictor을 선형결합해 M개로 만들어 M < p인 M차원 공간에 Y를 직교투영합니다. 이렇게 탄생한 M개의 변수를 latent variable이라고 합니다.

- 이 부분은 조금 더 공부해서 정리해야겠네요.

이런 변수 선택 방법들 중에서 AIC, BIC, Mallow's Cp는 Subset Selection에서 좋은 모델을 고르는 방법 중 하나로 사용됩니다. 위에서 말했던 것 처럼 RSS(잔차제곱합), 결정계수를 보고 적절한 모델을 선택하게 되는데 결정계수는 설명변수 갯수가 많으면 증가할 수 밖에 없습니다. 그래서 이러한 부분을 조정하기 위해 수정된 결정계수, AIC, BIC, Mallow's Cp등을 보고 적절하게 판단합니다.

Mallow's Cp

Cp는 bias가 적은 방향으로 변수를 선택하며, 변수의 수와 비슷할수록 더 좋다고 판단하는 것입니다.

변수를 추가하면 RSS가 감소하지만 2p가 패널티로 작용하여 p개로 fitting 했을 때, Cp가 p보다 작으면 좋은 모델로 선택하는 것입니다. 즉, Cp≈p에 가까워질수록 bias가 없다고 판단합니다.

AIC(Akaike Information Criterion)

변수가 많은 모델이라면(p가 큰) RSS는 작아지게 됩니다. 결국 AIC, BIC를 최소화 한다는 뜻은 우도(likelihood)를 가장 크게 하는 동시에 변수 갯수는 가장 적은 최적의 모델(parsimonious & explainable)을 의미하게 되는 것입니다. Bias는 변수를 제거하면서 생기는 오류이고 Variance는 변수가 증가하면서 생기는 오류입니다. 우도를 사용하는 것은 아래 그림과 같이 변수 갯수에 따른 bias와 variance 관계에서 최적의 모델 선택을 위한 균형점을 제시하기 위한 것입니다.

AIC의 식을 보면 모델의 파라미터(베타) 추정 방식이 MLE일 경우, 최대화된 Log-Likelihood 변수 추가에 따른 패널티 항(p)을 추가했습니다.

다시 정리해보면 -2Log(Likelihood)는 모형의 적합도를 의미하고, p는 모형의 추정된 파라미터의 개수를 의미하며 해당 모형에 패널티를 주기 위해 사용합니다. 실제로 어떤 모형이 적합도(-2Log(Likelihood))를 높이기 위해 여러 불필요한 파라미터를 사용할 수도 있습니다. 실제 모형 비교 시 독립변수가 많은 모형이 적합도 면에서 유리하게 되는데, 이는 독립변수에 따라서 모형의 적합도에 차이가 난다는 의미입니다. 따라서 이를 상쇄시키기 위하여 불필요한 파라미터, 독립변수의 수가 증가할수록 2k를 증가시켜 패널티를 부여하여 모델의 품질을 평가합니다.

따라서 2k가 증가할수록 AIC 값이 증가하게 되므로 좋지 않은 모형이 된다고 볼 수 있습니다.

BIC(Bayes Information Criterion)

AIC와 유사하지만 마지막 패널티를 수정함으로써 AIC를 보완했습니다. BIC의 경우 변수가 많을 수록 AIC보다 더 페널티를 가하는 성격을 가집니다. 예를 들어 BIC의 우변 log(n)p 에서 보통 n이 8이상이므로 log(8)>2가 됩니다. 따라서 AIC 보다 변수 증가에 더 민감해 변수 갯수가 작은 것이 우선 순위라면 AIC보다 BIC를 참고하는게 좋습니다.

-참고영상

백문이 불여일견이라고 영상으로 확인하시면 더욱 빠르게 이해 될 것입니다.

출처

http://blog.naver.com/PostView.nhn?blogId=euleekwon&logNo=221465294530

'나는야 데이터사이언티스트 > 통계' 카테고리의 다른 글

| 모델 성능 평가 지표 (회귀 모델, 분류 모델) (0) | 2020.06.24 |

|---|---|

| 교차검증(Cross-Validation) 쉽게 이해하기 (0) | 2020.06.04 |

| 최대우도추정법 쉽게 이해하기 (2) | 2020.05.13 |

| Ridge regression(릿지 회귀)와 Lasso regression(라쏘 회귀) 쉽게 이해하기 (0) | 2020.04.30 |

| 선형회귀분석(linear regression analysis) (0) | 2020.04.11 |